- ÉLECTRONIQUE (INDUSTRIE)

- ÉLECTRONIQUE (INDUSTRIE)L’utilisation du mot électronique dans sa présente acception est relativement récente: jusqu’aux années cinquante, ce vocable se rapportait le plus souvent à la seule discipline qui traitait du mouvement des électrons dans le vide, et ce qu’on appelle maintenant l’électronique était qualifié de radioélectricité, voire de télégraphie – ou de téléphonie – sans fil, plus connue sous le sigle T.S.F.La raison en est que, avant la Seconde Guerre mondiale, les applications de l’électronique se limitaient, pour l’essentiel, à la transmission par ondes radio et à la radiodiffusion.Aujourd’hui, l’électronique intervient dans la vie quotidienne de chacun, et le chiffre d’affaires de l’industrie électronique mondiale dépasse les quatre mille milliards de francs, dans les domaines les plus variés.On rappellera d’abord les principales étapes de cette révolution. Puis on classera, de façon assez arbitraire mais néanmoins classique, les différents domaines de l’électronique, qui seront examinés l’un après l’autre, à savoir: l’électronique professionnelle d’État, l’électronique professionnelle privée, l’électronique grand public, l’informatique et la bureautique, les télécommunications, les composants. Un autre mode de classification, moins classique mais très utile, sera ensuite indiqué et analysé. Enfin, l’évolution possible de l’industrie électronique ainsi que les conséquences qui en résulteront seront évoquées.1. HistoriqueTout historique non exhaustif – et aucun ne peut l’être – est criticable par le choix des événements considérés comme essentiels par l’auteur, et par le choix des inventeurs et des pionniers, puisqu’il est extrêmement rare qu’une découverte soit le fait d’un seul chercheur. Au demeurant, nombre de découvertes n’ont pas eu de suite immédiate pour force raisons, et d’autres, qui ne seront pas évoquées parce qu’elles n’apparaissent pas aujourd’hui avoir reçu d’applications, en auront peut-être plus tard, par exemple lorsque des découvertes de physico-chimie permettront de les utiliser de façon pratique.Quoi qu’il en soit, on peut sans doute faire remonter le début de l’électronique à l’année 1820, lorsque Hans Christian Œrsted découvre accidentellement l’effet d’un courant électrique sur une aiguille aimantée, et lorsque, peu après, André-Marie Ampère met en évidence l’effet d’un courant électrique sur une boucle parcourue par un courant électrique, premières transmissions d’une information à (très courte) distance. Ce phénomène est précisé en 1831 par Michael Faraday.Vers 1860, un Français d’origine italienne, l’abbé Giovanni Caselli, imagine l’analyse d’une image ligne par ligne, processus qui reste aujourd’hui la base d’une transmission de télévision. On peut voir au Conservatoire national des arts et métiers de Paris deux exemplaires de son «pantélégraphe». Cet appareil sera exploité par la Société des télégraphes, de 1867 à 1870: il servait à expédier des ordres de Bourse, permettant d’authentifier la signature du donneur d’ordre; à la réception, on utilisait une feuille de papier imbibée d’iodure de potassium sur laquelle le dessin apparaissait sous forme d’un tracé marron. Le premier télécopieur, sans doute, et le début de la télématique!James Clerk Maxwell résume quantitativement les lois de l’électromagnétisme à la fin des années 1860 et Alexander Graham Bell invente la téléphonie sur fil en 1875: il utilise les propriétés conductrices des fils métalliques pour transporter les variations de courant électrique produites par un microphone.C’est en 1879 que William Crookes produit les premiers rayonnements que Wilhelm Conrad Rœntgen – incertain qu’il était de leur véritable nature – baptisera rayons X en 1895, essentiels aujourd’hui en diagnostic médical.Une autre date clef se situe en 1887, lorsque Heinrich Rudolf Hertz explicite le fait qu’il n’existe pas de différence essentielle entre les ondes électromagnétiques de grandes longueurs d’onde et les ondes lumineuses, de très petites longueurs d’onde. Cette remarque fondamentale conduira, bien plus tard, au radar et aux faisceaux hertziens. Moins tard pourtant qu’on ne le pense couramment, puisque le premier «radar» exploitant la réflexion des ondes électromagnétiques sur les obstacles – le «télémobiloscope» – a été conçu en 1904 par l’Allemand Christian Hülsmeyer, sans suite pratique cependant jusqu’au début des années trente, lorsque des «radars» (qui ne s’appelaient pas encore ainsi) américains (développés par A. H. Taylor, L. C. Young et L. A. Hyland), français (développés par Pierre David, Maurice Ponte et Henri Gutton) et allemands seront réalisés; ils étaient capables de détecter le passage d’avions, sans toutefois mesurer directement leur distance.La véritable origine de la télégraphie sans fil date de 1897: Guglielmo Marconi, utilisant à la réception le «cohéreur» inventé par Édouard Branly en 1890 à l’emplacement de l’actuel Institut supérieur d’électronique de Paris, établit la première liaison radio, entre La Spezia et le navire militaire San Marino , distant de 16 kilomètres.Jonathan Adolf Wilhelm Zenneck réalise en 1899 un véritable oscilloscope (d’après les travaux de Ferdinand Braun en 1896) qui donnera naissance aux appareils de mesure et d’analyse aujourd’hui utilisés dans tous les laboratoires d’électronique, aux écrans dont se servent les contrôleurs du trafic aérien, et aux écrans de télévision.Les fondements de la théorie quantique sont jetés par Max Planck en 1900, sous une forme très sommaire, il est vrai. Nombre de savants vont la perfectionner. Cette théorie est à la base des lasers et de l’essentiel de l’optoélectronique.Cependant, il ne suffisait pas d’avoir énoncé les grandes lois de l’électromagnétisme et d’avoir obtenu des liaisons à relativement courte distance; il fallait disposer des organes (composants) capables, à court terme, d’émettre des puissances élevées et d’améliorer la sensibilité des récepteurs; à plus long terme, de manipuler et de filtrer les signaux reçus.Plusieurs découvertes essentielles ont lieu au début du XXe siècle, qui apportent les outils nécessaires: la triode, inventée en 1906 par Lee De Forest, sera, jusqu’à l’invention du transistor, l’organe essentiel de l’électronique; elle est encore utilisée dans certains émetteurs de très grande puissance (souvent sous la forme de tétrode).La réception à réaction, inventée en 1913 par Edwin H. Armstrong, et, surtout, la réception superhétérodyne, trouvée par Lucien Lévy en 1917-1918, vont permettre d’obtenir une sensibilité meilleure. Tous les récepteurs de radio sont encore superhétérodynes, comme les récepteurs de télévision, et la plupart des radars et des faisceaux hertziens.En ce qui concerne la prise de vue en télévision, il semble que la première conception d’une caméra correspondant à celles que l’on réalise encore aujourd’hui se trouve dans un brevet (sur un «iconoscope») de Vladimir Kosma Zworykin déposé en 1923. Il faut cependant noter que, sous sa forme primitive, ce dispositif n’était pas réalisable, et il faudra attendre 1925 pour que l’iconoscope, développé dans les laboratoires de la firme R.C.A., devienne opérationnel.Le premier magnétron est réalisé par Albert Wallace Hull en 1924 et perfectionné par les Français Maurice Ponte et Henri Gutton entre 1935 et 1939; il contribuera à améliorer les radars d’une manière décisive lors de la Seconde Guerre mondiale, car il était capable de produire des puissances élevées à des longueurs d’onde décimétriques et centimétriques. Le magnétron est aujourd’hui le composant essentiel des fours à micro-ondes.Le klystron, qui est chronologiquement le deuxième type de tubes générateurs ou amplificateurs de micro-ondes, est inventé en 1936 (en même temps donc que les magnétrons modernes) par G. F. Metcalf et W. C. Hahn. Il s’agit du premier des tubes dits à modulation de vitesse, ou tubes O, dans lesquels l’énergie électrique donne aux électrons une énergie cinétique qui se transforme en énergie électromagnétique, alors que dans les tubes M tels que le magnétron, l’énergie électrique communique aux électrons de l’énergie potentielle, laquelle est transformée en énergie électromagnétique. Le klystron est encore très largement utilisé dans les radars, dans les faisceaux hertziens, dans les accélérateurs de particules, dans les lasers à électrons libres, etc.Parmi les autres tubes O descendant du klystron, on trouve les tubes à onde progressive (T.O.P.), qui équipent aujourd’hui nombre de radars et de satellites, et parmi les tubes M, les tubes amplificateurs à champs croisés qui équipent également beaucoup de radars.Le Japonais Yagi Hidetsugu, qui avait par ailleurs travaillé immédiatement après Hull sur le magnétron, est le chercheur dont l’invention est peut-être la plus familière à chacun, pratiquement sous sa forme initiale, inchangée, puisque les antennes individuelles constituées d’un certain nombre de dipôles, utilisées à l’entrée des récepteurs de télévision, et que l’on trouve sur presque tous les toits, ont été réalisées pour la première fois par cet inventeur en 1926. On les appelle d’ailleurs très souvent des yagis.C’est sans doute Dauvilliers qui imagine pour la première fois, en 1928, l’utilisation d’un oscilloscope pour transformer le signal électrique en image de télévision, en somme ce que l’on fait toujours aujourd’hui.Le premier magnétophone semble avoir été utilisé en Allemagne en 1938, par une station de radiodiffusion.Alors que jusqu’en 1930 les applications à grande échelle de la «radioélectricité» étaient essentiellement les transmissions militaires (le général français Gustave Ferrié avait beaucoup contribué au développement des transmissions «sans fil» pendant la Grande Guerre), les années trente vont voir le début de l’électronique grand public, avec l’apparition des récepteurs radio à haut-parleur et des «pick-up», les balbutiements de la radionavigation à l’aide d’ondes radio, en même temps que les premiers développements de la physique des solides, par Felix Bloch et Allan H. Wilson (le transistor M.O.S. – metal oxyde semiconductor – a été imaginé dès le début des années trente).La Seconde Guerre mondiale a pour conséquences un extraordinaire développement du radar, des faisceaux hertziens, des moyens de radionavigation et de radiocommunications; on assiste, au début de la détection infrarouge, aux premiers balbutiements de la théorie de l’information (par Norbert Wiener).C’est à la fin du conflit que John von Neumann met à profit, aux États-Unis, les idées émises en 1936 par le Britannique Alan Turing. Aujourd’hui encore, la plupart des calculateurs numériques universels (improprement appelés ordinateurs) fonctionnent suivant les conceptions de von Neumann et, même si un Allemand, Konrad Zuse, a sans doute réalisé en 1944 le premier calculateur numérique opérationnel, on s’accorde à donner comme point de départ de l’informatique moderne la réalisation en 1945 de l’E.N.I.A.C. (Electronic Numerical Integrator And Computer) construit par les Américains J. Presper Eckert et John Mauchly, énorme machine de 30 tonnes contenant 18 000 tubes électroniques dissipant une puissance énorme. À titre de comparaison, un microprocesseur contient de 0,6 à 4 millions de composants sur une «puce» de 1 centimètre carré environ.Mais il est probable que l’informatique n’aurait connu qu’un développement notable, sans plus, si deux événements considérables n’étaient survenus: la réalisation, en 1948, du premier transistor à pointe (par William Bradford Shockley, John Bardeen et Walter H. Brattain) et la mise au point, en 1958, au sein de la firme Fairchild Semiconductors (par Jean Hoerni), de la technologie «planar» conduisant aux circuits intégrés contenant aujourd’hui jusqu’à environ un million de transistors sur le même (très) petit composant. Le germanium, qui avait au début permis de réaliser les premiers transistors et les premiers récepteurs radio à transistors, sera vite définitivement abandonné au profit du silicium, dont l’extraordinaire stabilité de son dioxyde (en somme, le sable), très facile à élaborer, permettra au physico-chimistes de progresser extrêmement rapidement dans la voie de la densification des fonctions électroniques.Un autre groupe de matériaux semiconducteurs, les composés dits III-V – associant des atomes à trois électrons périphériques, comme le gallium, l’indium et l’aluminium, à des atomes à cinq électrons périphériques, comme le phosphore et l’arsenic – permettent de réaliser les premiers circuits intégrés entre 1974 et 1976, avec à la fois, pour les premiers circuits intégrés en arséniure de gallium, des propriétés de grande rapidité et de résistivité élevée qui leur permettaient des applications au calcul rapide et/ou en micro-ondes, et des possibilités d’utilisation en optoélectronique (réalisation de petits lasers aujourd’hui utilisés en télécommunication sur fibres optiques ou sur des fusées de proximité). La possibilité de réaliser avec ces matériaux, grâce à des méthodes nouvelles (épitaxie par jet moléculaire), des couches superposées extrêmement fines (épaisseurs d’un ou de plusieurs atomes) de matériaux différents, les moyens modernes de dopage par implantation (un matériau semiconducteur doit souvent comprendre un pourcentage très faible, mais bien contrôlé, d’impuretés que l’implantation injecte en force dans le matériau de base) permettent d’élaborer des structures nouvelles (par rapport aux structures classiques de transistors), et, par là, d’accéder à des performances, donc à des applications nouvelles.Ces outils, fournis par la physico-chimie moderne, ont petit à petit permis d’appliquer les idées des spécialistes du traitement du signal (Claude Shannon, 1948; P. M. Woodward, 1949) qui, à partir d’une réflexion sur la nature des problèmes à résoudre, avaient souvent ouvert la voie à des solutions inédites de problèmes anciens, par l’utilisation d’outils mathématiques parfois très anciens (transformations de Laplace-Carson, de Fourier), parfois redécouverts (transformation de Fourier rapide, déjà utilisée en fait par Butler de nombreuses années auparavant). C’est ainsi qu’ont été peu à peu utilisées les notions de «compression d’impulsion» (en radar) ou de modulation à spectre étalé (la même technique, mais appliquée aux télécommunications), de filtre adapté, de filtres transverses, de filtrage auto-adaptatif, etc., qui ont changé le domaine d’application des fonctions électroniques classiques ou encore ouvert la voie à des applications nouvelles (compression de la parole, parole artificielle, réduction de la largeur de bande nécessaire à la transmission des images, etc.).Les spécialistes du traitement du signal ont même parfois incité les techniciens à créer des composants inédits adaptés à leurs problèmes (filtres électro-acoustiques à ondes de surface, inventés en France en 1967-1968 par Charles Maerfeld, Eugène Dieulesaint et Pierre Harteman, de la société Thomson-C.S.F.).Les méthodes de physico-chimie développées pour l’industrie des semiconducteurs et convenablement adaptées ont permis de réaliser des fibres de verre très pur et de constitution bien contrôlée, rendant possible le transfert à longue distance d’une grande quantité d’information sous forme lumineuse dans des fibres optiques grâce à l’utilisation de dispositifs optoélectroniques.Si les triodes et les klystrons peuvent aujourd’hui fournir des puissances énormes, c’est grâce à l’utilisation de dispositifs de refroidissement nouveaux et performants (le «vapotron», inventé en 1950 par Charles Beurtheret, de la société Thomson-C.S.F.), grâce à la triode à grilles en graphite pyrolithique (Thomson-C.S.F., vers 1960), grâce aussi, pour les klystrons et les tubes à onde progressive, à l’utilisation, sur des calculateurs très puissants, de programmes de calculs importants.Des programmes de même nature permettent de concevoir et de réaliser des antennes de forme nouvelle, beaucoup plus performantes que les anciennes, et, sans la conception assistée par ordinateur, personne ne pourrait sérieusement envisager de réaliser des composants (microprocesseurs, etc.) comportant plusieurs millions de transistors par puce.Ces chercheurs, et bien d’autres, qui n’ont pas été cités, ont fait de l’industrie électronique des années quatre-vingt-dix une industrie majeure.2. La révolution des circuits intégrésJusqu’au milieu des années soixante, les équipements électroniques ont été construits essentiellement par association de composants individuels. Certaines fonctions complexes (de filtrage, de commutation, etc.) pouvaient bien être réalisées, dans le domaine des micro-ondes, par des «dispositifs», mais la très grande majorité des fonctions étaient élaborées par association de composants actifs (diodes, triodes puis transistors) et de composants passifs (condensateurs, inductances – ou selfs –, résistances, etc.) que l’on reliait (interconnectait) par des conducteurs électriques. Jusqu’au milieu des années cinquante, une fonction était réalisée sur un support rigide (le châssis) auquel étaient accrochés les éléments interconnectés par des câblages filaires (fils de cuivre recouverts d’un isolant). L’arrivée des transistors, moins encombrants et plus légers, a conduit petit à petit à la généralisation des cartes imprimées (ou circuits imprimés), c’est-à-dire de dispositifs supports, le plus souvent rigides, sur lesquels sont imprimées les interconnexions métalliques qui permettent de réaliser les connexions convenables entre les composants rapportés sur la carte. La complexité des circuits nécessitant souvent plusieurs couches d’interconnexions, des circuits imprimés multicouches ont commencé à être utilisés dès le début des années soixante; ces circuits imprimés multicouches sont constitués de plusieurs (jusqu’à 20) épaisseurs de feuilles isolantes imprimées d’interconnexions métalliques; ils sont percés de trous qui permettent d’enficher les «queues» métalliques des composants soudés aux interconnexions métalliques.Une énorme révolution est intervenue au milieu des années soixante, avec l’arrivée des circuits intégrés, c’est-à-dire de pastilles – de silicium, d’abord, puis, au début des années quatre-vingt, d’arséniure de gallium – de petite dimension (le plus souvent inférieures à 1 cm2) comportant elles-mêmes d’abord une fonction complète, c’est-à-dire plusieurs transistors et les composants passifs associés, puis un ensemble de fonctions, enfin un véritable petit équipement (par exemple une matrice de commutation téléphonique ou un calculateur complet dit microprocesseur).Le problème devient alors d’interconnecter les quelques circuits intégrés qui seront nécessaires pour réaliser l’équipement, chaque circuit intégré ayant d’autant plus de sorties et d’entrées qu’il comporte de transistors internes (on atteint plusieurs centaines de «pattes» lorsque le circuit intégré comporte plusieurs centaines de milliers de transistors). La conception du schéma d’interconnexion et la façon pratique de le réaliser (multicouche, câblage utilisant partiellement de l’optique) pourront être difficiles et nécessiteront de puissantes aides informatiques. La réalisation pratique devra être effectuée le plus souvent avec peu d’intervention humaine mais avec des outillages automatiques.La fabrication des équipements électroniques à base de circuits intégrés effectuant chacun un nombre de plus en plus grand de fonctions par des modes d’assemblage de moins en moins manuels est la première caractéristique de l’évolution de l’électronique dans les années soixante-dix et quatre-vingt, qui conduit clairement à une diminution constante du temps de fabrication par fonction à remplir.L’autre caractéristique essentielle a trait à la méthodologie des essais. Dans les années cinquante, un équipement électronique était essayé à la main par un technicien qui testait point par point le bon état de la «circuiterie» (et, au besoin, très souvent, faisait l’éventuelle réparation).Quatre phénomènes, se complétant et se «poussant», ont conduit, durant les années quatre-vingt, à la généralisation de tests automatiques par des machines utilisant des calculateurs; il s’agit:– du caractère plat et parfaitement reproductif des circuits imprimés, qui permet de positionner automatiquement des testeurs par points;– de l’apparition de calculateurs performants et rapides, qui permettent de répéter sans erreur des séquences de test mises au point une fois pour toutes (avec beaucoup d’intelligence) par des ingénieurs concepteurs de test;– du plus grand nombre de mesures à faire (augmentation des performances des équipements électroniques conçus), qui nécessite des «bancs de mesures» automatiques et rapides;– de l’utilisation de plus en plus fréquente de l’électronique numérique, aux lieu et place de l’électronique analogique (en numérique, à un instant et à un endroit donnés, il n’y a que deux états possibles, alors qu’en analogique il y en a une infinité), qui facilite les tests automatiques mais n’est guère compatible avec des tests manuels à cause du nombre extrêmement grand de combinaisons des deux états possibles en chacun des points du circuit.Ainsi assiste-t-on à une diminution permanente du temps d’essai par fonction à remplir.L’industrie électronique correspond donc à une augmentation de la complication de la conception des équipements et de leurs essais, en même temps qu’à une amélioration permanente de la productivité (temps de fabrication et d’essai par fonction à remplir).Les investissements importants de conception, d’outillage de fabrication et d’essais devront s’amortir sur des fabrications en grand nombre (matériels grand public) ou pouvoir servir à différents équipements (conception modulaire des équipements d’électronique professionnelle, où les mêmes sous-ensembles sont utilisés dans différentes familles d’équipements).Si l’on essaie de définir quel était à la fin des années quatre-vingt le taux d’amélioration de la productivité d’un équipement électronique, on se rend vite compte de la difficulté du problème, en particulier parce qu’on compare des choses difficilement comparables entre elles (une calculette de poche est maintenant plus performante qu’un calculateur de plusieurs mètres cubes de 1960), mais aussi parce que toutes les branches de l’électronique n’ont pas évolué de la même façon (l’industrie téléphonique avait peu évolué entre 1920 et 1970, avant de se précipiter, en se «numérisant», dans une révolution technique et industrielle de 1975 à 1985).Il n’est probablement pas faux de dire qu’en moyenne, à la fin des années quatre-vingt, la productivité s’améliorait d’environ 6 p. 100 par an. Ce qui signifie, d’une certaine façon , qu’une diminution de chiffre d’affaires de 6 p. 100 par an sur plusieurs années correspond en fait à un nombre constant d’équipements vendus par an (de lignes téléphoniques installées, etc.). Cela doit être conservé en mémoire lorsqu’on examine le tableau qui indique la répartition de l’activité de l’industrie électronique à la fin des années quatre-vingt, avec toutes les réserves d’usage sur ce genre d’évaluation, où l’on additionne des dollars, des yens, des livres, des marks et des francs en tenant compte de certains taux de change, où les sources d’information sont souvent très imprécises.Il est également intéressant de noter que les évaluations dans ce tableau ne tiennent pas compte de la production des pays communistes (faute d’avoir les renseignements correspondants) et que la répartition du chiffre d’affaires total de 4 000 milliards de francs français s’effectue grosso modo comme suit: États-Unis d’Amérique: 52 p. 100; Japon: 25 p. 100; Europe: 20 p. 100; autres: 3 p. 100. Par ailleurs, il est toujours difficile, dans ces statistiques, de savoir si un chiffre d’affaires européen contient ou ne contient pas la production effectuée dans un pays d’Extrême-Orient pour le compte d’un groupe industriel européen.3. L’électronique professionnelle d’ÉtatL’électronique professionnelle d’État est sans doute la première à avoir connu un réel développement avec les applications militaires de la radio (effectuées par le général Ferrié pendant la Première Guerre mondiale). Ce vocable regroupe essentiellement, dans les statistiques, des équipements et des services vendus à des États ou à des organismes d’une envergure analogue (grosses compagnies de transport aérien, constructeurs d’avions de ligne, E.D.F. ou équivalents...).L’électronique professionnelle d’État concerne à 80 p. 100 le domaine militaire. Ses différentes activités sont:– les communications militaires et la téléphonie associée (les «transmissions»), qui ont constitué sa première activité;– la détection et le contrôle de la navigation (radars de surface ou radars de surveillance montés sur plates-formes volantes, et systèmes de manipulation des données correspondantes, avec les «faces parlantes», écrans et informations tabulaires de toute nature permettant aux contrôleurs de diriger les évolutions des avions, navires et autres mobiles;– les aides à la navigation (systèmes permettant aux mobiles de se situer géographiquement, à partir d’informations radioélectriques provenant du sol ou de satellites) et à l’atterrissage (aides automatiques comme l’I.L.S. – instrument landing system –, ou les plus récents M.L.S. – microwave landing system –, ou P.A.R. – precision approach radar ), permettant à des opérateurs au sol d’aider par la voix les pilotes d’avions à se poser;– la détection des sous-marins par des sonars actifs (analogues aux radars mais envoyant un signal sonore ou ultrasonore dans l’eau pour récupérer ensuite l’écho renvoyé par le sous-marin) ou passifs (écoutant les bruits émis par les sous-marins pour les analyser ensuite);– l’armement des avions de combat (radars permettant d’indiquer au pilote la position de l’adversaire et l’aidant à l’attaquer ou à se défendre, radars permettant le vol à basse altitude, etc.);– l’équipement des missiles (fusées de proximité, autodirecteurs), des obus (fusées de proximité), des torpilles (guidage);– les systèmes au sol permettant le guidage des missiles surface-air;– les équipements de simulation permettant de façon plus économique et sans risque d’apprendre à piloter des avions, des chars, des centrales nucléaires;– les émetteurs radios et les émetteurs ou réémetteurs de télévision;– l’équipement des satellites scientifiques et d’application (photographie aérienne en visible, en infrarouge, en radar).Les techniques utilisées recouvrent très largement le domaine des ondes électromagnétiques très longues (pour la transmission militaire, on va jusqu’à utiliser des longueurs d’onde de 10 000 kilomètres), moyennes, courtes, pour les radiocommunications, des micro-ondes (de quelques dizaines de centimètres à quelques millimètres) pour la détection et les communications, des ondes micrométriques (infrarouge et lumière visible) pour la détection et la transmission (sur fibres optiques).L’électronique professionnelle fait aussi usage des ultrasons, à la fois comme outils de traitement du signal et comme signal de base (dans la détection et les transmissions sous-marines).L’électronique professionnelle d’État utilise des équipements de plus en plus sophistiqués, qui doivent pouvoir fonctionner dans n’importe quel contexte, en dépit des perturbations atmosphériques, des signaux parasites et des contremesures de l’adversaire (brouillages aveugles ou dispositifs de leurrage), qui cherchent à écouter en temps de paix pour préparer la guerre (écoute stratégique), ou en temps de guerre pour neutraliser les moyens adverses.Les équipements de l’électronique professionnelle d’État, qui sont souvent amenés à fonctionner dans des conditions climatiques difficiles, sont fabriqués en petit nombre (les fabrications dépassent rarement quelques milliers d’unités par an, sauf pour les fusées de proximité d’obus; elles sont parfois de quelques unités par an, voire d’un équipement tous les cinq ans). Ils ne peuvent donc pas être fabriqués sur des chaînes entièrement automatiques équipées de machines-transferts ou matériel équivalent, mais plutôt dans des ateliers flexibles, avec des machines capables de produire dans la même journée différents types de produits. En raison de quoi et à cause de leur sophistication ultime, ils ne peuvent pas avoir en fait la fiabilité des matériels grand public fabriqués à plusieurs millions d’exemplaires par an de façon extrêmement automatisée. En revanche, ils sont très souvent utilisés par du personnel extrêmement compétent, qui a reçu la formation nécessaire pour connaître les équipements en question et savoir s’en servir, assurer une maintenance préventive (mesures destinées à éviter les pannes), dépanner les équipements rapidement (par changement de sous-ensembles).Les équipements d’électronique professionnelle d’État sont le plus souvent organisés en systèmes (systèmes d’armes, systèmes de contrôle, systèmes de communications...) constitués d’un certain nombre d’équipements s’échangeant des informations (sous forme de plus en plus numérique), informations simples ou complexes (images colorées), qui sont stockées en plusieurs endroits mais accessibles à chaque instant. La part de traitement numérique augmente chaque jour, ce qui permet une plus grande souplesse d’emploi, sous réserve que les organes de calcul qui gèrent les systèmes et traitent l’information soient pilotés par des programmes suffisamment complexes, leur permettant de réagir à temps en cas d’événements imprévus: on dit qu’il s’agit d’informatique en «temps réel». Les programmes correspondants (les logiciels) sont de plus en plus gros, donc de plus en plus difficiles à mettre en œuvre.La structure de l’industrie électronique professionnelle d’État était extrêmement dispersée après la Seconde Guerre mondiale, particulièrement en France, où il convenait de reconstruire, et où toute bonne volonté un peu compétente trouvait sa place pour un temps. Les industriels les plus importants des États-Unis (General Electric, R.C.A., Raytheon, etc.) réalisant des matériels très sophistiqués au prix d’investissements énormes en recherche et en développement (de 30 à 35 p. 100 du chiffre d’affaires), essentiellement financés (à un niveau supérieur à 80 p. 100) par le ministère de la Défense, la structure dispersée s’est progressivement révélée inefficace pour envisager de rester en France à un niveau compétitif. Les années 1960 et 1970 ont vu une considérable réduction du nombre des industriels français, dans le but de mieux utiliser les ressources disponibles pour la recherche et le développement (environ 20 à 25 p. 100 de l’activité). Des évolutions analogues se sont produites en R.F.A. et en Italie ainsi qu’à un niveau moindre en Grande-Bretagne (où la tentative de rachat de Plessey par G.E.C. Marconi, société résultant elle-même de la réunion de plusieurs sociétés notables, avorta).La situation de l’électronique professionnelle d’État de la fin des années quatre-vingt est caractérisée, en premier lieu, par l’absence de vrai «grand» (les cinquante premières sociétés font 88 p. 100 du chiffre d’affaires, mais la première n’en fait que 8 p. 100), en deuxième lieu, par la présence très importante des États-Unis (qui réalisent 75 p. 100 du chiffre d’affaires, alors que l’Europe en réalise 22 p. 100 et le Japon 2 p. 100, toujours hors pays communistes), avec huit sociétés américaines dans les dix premières contre deux européennes (Thomson-C.S.F. et G.E.C. Marconi), enfin, par une faiblesse du Japon, due en partie à la doctrine japonaise selon laquelle jusqu’en 1987 le budget militaire ne pouvait dépasser 1 p. 100 du P.N.B., et aussi au fait que le Japon ne peut exporter d’armement (le budget militaire du Japon dépasse 1 p. 100 du P.N.B. depuis 1987).Enfin, il convient de rappeler que l’ensemble du chiffre d’affaires de l’électronique professionnelle d’État représentait à la fin des années quatre-vingt un montant un peu supérieur à 600 milliards de francs français, c’est-à-dire 15 p. 100 du chiffre d’affaires de l’industrie électronique.4. L’électronique professionnelle privéeOn regroupe sous la rubrique électronique professionnelle privée – correspondant à 10 p. 100 du chiffre d’affaires mondial de l’électronique – un ensemble d’activités toutes en expansion moyenne et de création relativement récente: l’électronique médicale, l’électronique automobile, l’équipement des studios de télévision, le contrôle industriel et l’instrumentation, la sécurité et la surveillance localisées.L’électronique médicale comprend l’imagerie médicale d’aide au diagnostic, les équipements de soins que sont les irradiateurs (par rayons X, par neutrons, etc.), les équipements destinés à pallier des insuffisances cardiaques (tels que les cardiostimulateurs portatifs appelés «pacemakers») ou les équipements utilisés pour combattre des déficiences du muscle cardiaque (défibrillateurs).L’imagerie médicale d’aide au diagnostic utilise trois types de rayonnements: les rayonnements ultrasonores, dans des équipements d’imagerie analogues aux sonars et baptisés échographes; les rayonnements fournis par des éléments radioactifs ingérés par le patient (médecine nucléaire) et fournissant par exemple des informations sur le métabolisme; les rayonnements X, rayonnements électromagnétiques de très courte longueur d’onde.Depuis peu, des rayonnements à fréquence relativement faible (de l’ordre de celles qui sont employées en radiocommunications militaires ou acoustiques) sont utilisés dans les appareils de résonance magnétique nucléaire.Le marché de l’imagerie médicale a été complètement bouleversé lorsque les premiers «scanners», inventés par des radaristes de la société britannique E.M.I., sont apparus dans les années soixante-dix; dans ces appareils, l’image est reconstituée par un calculateur à partir d’un très grand nombre d’informations (grand nombre de capteurs de rayons X, grand nombre de positions de l’émetteur de rayons X). De tels appareils sont d’un niveau de sophistication très supérieur aux anciens imageurs X, avec un émetteur hyperfréquence très soigné, une mécanique de haute précision, un traitement du signal très élaboré; ils ressemblent plus à un radar qu’à un imageur X ancien!Le métier du fabricant d’imageurs X s’en est trouvé bouleversé, avec la nécessité de procéder à des investissements considérables en recherche et développement (au regard du chiffre d’affaires immédiat, voire attendu). Les grands du métier, filiales ou départements de groupes importants, y ont perdu beaucoup d’argent, alors que de nouveaux venus ambitieux essayaient de profiter de l’occasion pour s’implanter dans ce nouveau marché, le plus souvent sans succès.L’importance de l’imagerie médicale a été confirmée dans les années quatre-vingt avec les imageurs utilisant la résonance magnétique nucléaire, appareils également d’un degré élevé de sophistication et nécessitant un gros investissement en recherche et développement.À la fin des années quatre-vingt, la situation était la suivante: seuls avaient survécu un petit nombre de groupes, puisque trois sociétés se partageaient 60 p. 100 du marché mondial des imageurs médicaux (General Electric, après absorption de la société française C.G.R., Philips, après absorption de la société britannique Pickers, et Siemens); elles étaient suivies par deux firmes japonaises (Toshiba et Hitachi) qui couvraient surtout les besoins du Japon; les cinq premières sociétés couvraient pratiquement 80 p. 100 du marché mondial, estimé à 60 ou 70 milliards de francs à la fin des années quatre-vingt.L’électronique automobile en est à ses débuts: ce n’est qu’à la fin des années soixante-dix que l’on a commencé à utiliser sur une échelle assez grande l’allumage électronique dit intégral, les calculateurs de bord, les systèmes antidérapage (A.B.S., anti blocking system ) utilisés depuis longtemps sur les avions de ligne; avant la fin du XXe siècle, des systèmes d’aide à la navigation, à l’anticollision, etc., apparaîtront sur le marché.À l’inverse des équipements d’électronique médicale, les équipements d’électronique automobile sont fabriqués en très grande série; de ce point de vue, ils s’apparentent aux équipements d’électronique grand public, avec en plus des impératifs de sécurité qui n’existent évidemment pas pour l’électronique grand public (aux États-Unis, des systèmes électroniques de commande de freinage ont été mis en panne par le rayonnement de radars de contrôle de vitesse, ce qui est évidemment intolérable).En pratique, une partie significative de l’industrie de l’électronique automobile est incorporée chez les fabricants d’automobiles, ou chez des sous-traitants en dépendant étroitement.L’électronique automobile verra son importance croître, ce qui nécessitera, afin d’éviter des interférences catastrophiques, l’utilisation de câblage en fibres optiques.Alors que l’électronique automobile s’apparente définitivement à l’électronique grand public, l’équipement des studios de télévision et des moyens mobiles de reportage constitue un ensemble d’équipements et de services hésitant entre la physionomie «professionnelle» d’équipements sophistiqués faits en petit nombre (caméras lourdes de prises de vue avec d’énormes zooms, coûtant de un à plusieurs millions de francs, matériel sophistiqué de mélange et de trucage, analyseurs d’images fixes et télécinémas de très haute qualité) et la physionomie «grand public» de l’utilisation de matériel de large diffusion (caméras et magnétoscopes).L’industrie de l’équipement des studios de télévision survivra ou disparaîtra, selon que la balance penchera du premier côté, avec par exemple l’arrivée assez rapide de la télévision haute définition (plus de 1 000 lignes à plus de 1 000 points) et son utilisation pour le cinéma (il est plus facile de faire des manipulations d’images avec les techniques «vidéo» de la télévision qu’avec les techniques conventionnelles du cinéma), ou du second côté, si l’on constate que la qualité acquise en télévision au milieu des années quatre-vingt se révèle en fait suffisante pour assez longtemps, donnant ainsi au matériel de large diffusion le temps nécessaire pour atteindre progressivement la qualité désirée.Le contrôle industriel et l’instrumentation ont pour mission de fournir à un nombre pouvant être assez important d’utilisateurs – spécialistes le plus souvent – des moyens de mesure et d’analyse leur permettant de mener leur action dans les meilleures conditions. C’est dire que le concepteur d’un instrument doit le plus souvent connaître parfaitement le domaine d’utilisation de cet instrument, et qu’il y a autant de familles d’instruments que de domaines. Les instruments sont généralement installés dans un grand nombre d’endroits différents; s’ils nécessitent une maintenance de la part du constructeur, il y a donc lieu pour celui-ci de disposer de personnel d’après vente à proximité des utilisateurs. Enfin, si une personne ou un groupe de personnes sont amenés à concevoir un instrument inédit sur un principe nouveau et que cet instrument apporte aux utilisateurs des services très supérieurs aux instruments présents, le (ou les) concepteur(s) auront l’occasion d’une percée industrielle et commerciale qui, bien exploitée, pourra conduire à la création d’une société (petite ou grande) solide et prospère, au moins tant que l’envie de la diversification ne la conduira pas à vouloir sortir de sa spécialité (l’examen de la création et de la vie de grosses sociétés comme Hewlett-Packard, Schlumberger, Tektronix, Perkin Elmer... ou de petites, comme la française Cameca, est instructif à cet égard).On notera aussi qu’il pourra être très difficile de pénétrer dans un domaine de l’instrunentation lorsqu’un autre s’y est déjà fait un nom et dispose du réseau commercial bien introduit.La sécurité et la surveillance localisées correspondent à des besoins évidents qui ne font que croître et qui sont aujourd’hui de deux natures: celui, relativement grand public, de protéger des appartements, des pavillons, des automobiles, aujourd’hui assuré par un très grand nombre de petits fabricants, et le besoin professionnel de protéger des bases militaires, des centrales de production d’énergie, des plates-formes de forage pétrolier..., qui correspond à des installations lourdes, dont la nature et la composition restent souvent à définir.On peut s’attendre à ce que le premier besoin voit ses solutions se décanter petit à petit dans les années quatre-vingt-dix en faisant apparaître un catalogue d’un nombre réduit de produits à fabriquer alors en grande série par un «électronicien grand public», alors que le second restera beaucoup plus celui de solutions sophistiquées construites sur mesure par les industriels professionnels d’État.Hors tout, l’électronique professionnelle privée, dont on sent qu’elle ne constitue pas un tout homogène, et dont les constituants ne sont pas encore bien stabilisés dans leur définition, représentait à la fin des années quatre-vingt un chiffre d’affaires de 400 milliards de francs environ, réalisé à raison de 51 p. 100 aux États-Unis, de 29 p. 100 en Europe, de 18 p. 100 au Japon.5. L’électronique grand publicL’électronique grand public représente finalement, quoi qu’on puisse en penser a priori, un chiffre d’affaires moins important que la peu connue électronique professionnelle d’État, et qui se situait autour de 500 milliards de francs à la fin des années quatre-vingt.Ses productions n’ont pas grand besoin d’être décrites puisqu’elles sont connues de chacun: les statistiques regroupent sous l’appellation d’électronique grand public les téléviseurs, les chaînes hi-fi, les magnétophones et magnétoscopes, les lecteurs de disques, les récepteurs radio et les autoradios, les caméras vidéo, ainsi que les disques et cassettes enregistrées (qui constituent une branche à part, non de fabrication d’équipements, mais de programmes artistiques).Depuis le début des années cinquante, époque à laquelle l’industrie électronique grand public était éclatée en un grand nombre de petites sociétés fabriquant des appareils à tubes de façon quasi artisanale (voire tout à fait artisanale), de fiabilité très relative et nécessitant d’importantes prestations d’après vente, on a assisté à une évolution somme toute analogue à celle de l’industrie automobile, quoique bien plus rapide et s’intéressant à des produits d’un coût unitaire beaucoup plus faible. À la fin des années quatre-vingt, les produits de l’électronique grand public étaient fabriqués en très grande série dans des usines automatisées nécessitant des investissements importants: alors qu’à la fin des années soixante-dix, il fallait environ 20 heures de fabrication et d’essais par téléviseur couleurs, il en fallait moins de 2 à la fin des années quatre-vingt; on mesure l’énorme évolution de la productivité, résultant de sommes importantes investies dans les chaînes de fabrication, qu’il faut donc amortir sur de grandes quantités fabriquées.On comprend alors la nécessité de regrouper des industries; il en est résulté un jeu de fusions, rachats, absorptions entre la fin des années cinquante et la fin des années quatre-vingt pour passer de la multitude de petites sociétés artisanales aux quelques grands groupes dominant le débat aujourd’hui.À la fin des années quatre-vingt, les trois premiers groupes étaient le Japonais Matsushita, avec 16 p. 100 de la production mondiale (toujours hors pays communistes), le multinational (hollandais) Philips, avec 10 p. 100, et l’américano-européen Thomson, avec 10 p. 100 également, soit au total 36 p. 100 pour les trois premiers.Les sept suivants (tous japonais) réalisaient ensemble le même volume que les trois premiers: c’est dire que les sociétés japonaises produisaient pratiquement les deux tiers (65 p. 100) de l’électronique grand public, contre 31 p. 100 pour l’ensemble Europe-États-Unis.L’automatisation de la fabrication, grandement facilitée par le développement des circuits intégrés à haute densité, a eu des conséquences largement positives sur la fiabilité des équipements produits: la réduction au minimum des interventions humaines permet d’obtenir des produits très fiables, réduisant au minimum (voire à zéro) les interventions des dépanneurs d’après vente.6. L’informatique et la bureautiqueRelativement tard venue par rapport aux branches précédentes de l’électronique, puisque la plupart des machines informatiques utilisent le schéma de base défini par l’Américain John von Neumann à la fin de la Seconde Guerre mondiale, l’industrie de l’informatique et de la bureautique correspondait, à la fin des années quatre-vingt, à 40 p. 100 du chiffre d’affaires de l’industrie électronique, soit trois fois plus que l’électronique grand public et autant que l’ensemble des trois branches évoquées ci-dessus.La seule société I.B.M., pionnier du domaine, il est vrai (sa marque «ordinateur» est devenue un nom commun), a un chiffre d’affaires du même ordre de grandeur que celui de l’ensemble de l’électronique grand public; ajoutons que ce chiffre d’affaires est le quart du chiffre d’affaires total du domaine, de cinq à six fois plus élevé que celui de ses suivants immédiats (les Américains Xerox, plus tourné vers la bureautique, et Digital Equipment, essentiellement tourné vers l’informatique).L’activité des sociétés des États-Unis correspond à 68 p. 100 de l’activité totale du domaine (mais elles sont largement délocalisées), alors que les sociétés japonaises en occupent 18 p. 100 et les sociétés européennes 12 p. 100 (toujours hors pays communistes).L’ensemble informatique-bureautique recouvre les unités centrales des gros main frames , la mini-informatique, la micro-informatique, les télécopieurs, les photocopieurs et les logiciels et services.Les notions de main frame et de mini-calculateur ne correspondent pas dans le temps à des performances constantes, étant donné la très rapide évolution des circuits intégrés, qui permettent, sous le même volume et au même prix, de fournir des performances de plus en plus grandes.On parlera de main frames pour des machines de plus de 5 millions de francs, de «minis» pour des machines de l’ordre du million de francs et parfois de «mégaminis» pour des machines intermédiaires. Quant aux «micros», très souvent constitués autour d’un microprocesseur (circuit intégré comportant un très grand nombre de composants – plusieurs centaines de milliers de transistors – et assurant toutes les fonctions d’un cœur de calculateur), leur prix tourne autour de 10 000 francs ou moins et il en existe une énorme variété.L’existence des microprocesseurs est d’ailleurs en train de révolutionner le bas de gamme des machines informatiques, la possibilité d’acheter dans le commerce de tels composants à des prix raisonnables donnant à beaucoup d’électroniciens la faculté de créer des machines informatiques performantes adaptées à leurs besoins spécifiques.Comme il est possible d’utiliser des structures multiprocesseurs dans lesquelles plusieurs machines assez petites sont utilisées ensemble pour résoudre un problème donné, on conçoit que ces structures puissent être concurrentes des main frames. On distinguera les structures multiprocesseurs, dans lesquelles chaque processeur est affecté à une partie spécifique du travail à effectuer, et qui sont donc adaptées à la solution de problèmes prédéfinis (et qui sont assez répandues), et les structures multiprocesseurs «transparentes», dans lesquelles l’organisation apporte à n’importe quel processeur n’importe quelle partie du travail à mesure de leur disponibilité (ces structures encore peu répandues seront les vraies concurrentes des main frames).Si l’on ajoute que l’utilisation de machines informatiques en réseaux faisant travailler ensemble des machines situées en des endroits géographiques dispersés (sur un pays, un continent) est en train de se généraliser, on conçoit que l’on arrivera à des puissances de calcul sans aucune comparaison avec celles qu’on utilisait dans les machines informatiques de la fin des années cinquante.La puissance des configurations informatiques évoquées ci-dessus s’exprime assez habituellement en M.I.P.S. (pour millions d’instructions par seconde); il convient de dire «s’exprime» et non «se mesure» car la performance exprimée en M.I.P.S. ne peut donner qu’un ordre de grandeur, la performance réelle dépendant beaucoup de la nature du problème traité: pour un type de problème, on pourra effectuer des tests avec des problèmes types – des benchmarks – et on utilisera des mesures plus utiles et précises, comme le mégawheastone.En dépit de la puissance du numéro un mondial en informatique, on a vu dans les années soixante-dix certains constructeurs développer des familles de minis et de mégaminis qui ont connu et connaissent un succès certain, mieux adaptées qu’elles étaient à la solution de certains problèmes; la meilleure adaptation peut venir de la structure même de la machine, ou du fait que des machines analogues ont été utilisées par d’autres pour la solution des mêmes problèmes ou de problèmes voisins – le constructeur peut alors fournir à ses clients des programmes tout faits, éprouvés (avec peu ou pas d’erreurs).À ce moment du discours, il est important de comprendre que le prix et le volume des mémoires des machines informatiques étaient élevés au début, et qu’on essayait de ce fait d’utiliser les machines pour économiser de la mémoire (de façon à avoir besoin du volume de mémoire le plus petit possible). Le langage informatique utilisé qui permettait d’obtenir ce résultat était souvent celui qui était le plus proche du fonctionnement interne de la machine, l’«assembleur». Cela étant, les machines informatiques étaient conçues pour que la programmation de la machine en assembleur ne soit quand même pas trop contraignante: on appelait cette structure C.I.S.C. (complex instruction set computer ). L’évolution de la technologie des semiconducteurs et des circuits intégrés permet maintenant de considérer le plus souvent qu’une quantité importante de mémoire n’est pas coûteuse (non plus que volumineuse) mais qu’il faut en revanche faciliter la tâche des programmeurs (faire en sorte qu’ils programment beaucoup d’instructions à la journée, de façon fiable, pour que les programmes tournent bien dès le début, et de façon économique, pour que des morceaux entiers de programme puissent être récupérés dans d’autres applications). On développe pour ce faire des méthodologies précises (et contraignantes) de programmation (aidées par des outils graphiques supportés par des «stations de travail», ou workstations , qui sont en fait de vrais minis), dans lesquelles les programmeurs utilisent des langages de haut niveau, beaucoup plus proches du langage courant (le plus répandu dans le public est le Basic; l’un des premiers parmi les plus célèbres est sans doute le Fortran d’I.B.M.; les militaires américains ont standardisé le langage Ada défini par le Français Jean Ichbiah...). Ces langages de haut niveau ont besoin d’être traduits pour être compris par les machines (les programmes de traduction s’appellent des «compilateurs») et il n’y a dans ce cas aucune raison pour que le langage de l’intérieur même de la machine soit facile à utiliser; mais il doit être efficace et permettre de bonnes performances de vitesse. C’est ainsi que l’on est arrivé à la notion de machines R.I.S.C. (par opposition au C.I.S.C.), le R. de R.I.S.C., pour reduced , correspondant aussi au fait que l’on s’était rendu compte que beaucoup d’instructions du C.I.S.C. étaient en fait fort peu utilisées.La quasi-totalité des machines informatiques évoquées jusqu’ici fonctionnent en fait sur le schéma de von Neumann: «Je vais voir dans la mémoire de programmes ce que je dois faire maintenant – Je vais prendre dans la mémoire de données la donnée sur laquelle je dois agir – J’agis – Je retourne voir dans la mémoire de programmes...»Cette façon de faire, si elle s’est révélée adaptée à la solution de beaucoup de problèmes, n’est pas idéale pour obtenir la rapidité du calcul; aussi bien, lorsqu’on a besoin de faire toujours le même type de calcul très rapidement, utilise-t-on des machines adaptées, donc plus efficaces.C’est ainsi qu’en traitement du signal (radar, sonar, parole, etc.) on a besoin de calculer des transformées de Fourier; on utilisera dans ce cas des calculateurs de structures très différentes (effectuant les calculs en parallèle pour gagner du temps) à base de composants spécifiques dits «papillons» F.F.T. (fast Fourier transform ). On parlera parfois pour certaines machines de traitement du signal de machines S.I.M.D. (single instruction multiple data ).C’est ainsi également que lorsqu’un problème de calcul scientifique peut être traité sous forme de calculs vectoriels, on aura avantage à utiliser des calculateurs vectoriels (appelés souvent supercalculateurs).Les performances de toutes ces machines de pur calcul mathématique ne sont plus exprimées en M.I.P.S. mais en Flops (flotting point operations per second ), ou plutôt en mégaflops ou en gigaflops (un million ou un milliard de flops).À ce niveau, et pour compléter le décor informatique, il convient de dire quelques mots de ce qu’il est convenu d’appeler l’«intelligence artificielle» et les calculateurs neuroniques.Au début des années quatre-vingt-dix, l’intelligence artificielle, utilisée le plus souvent dans les systèmes experts, vise à s’inspirer des modes de raisonnement de l’homme pour recevoir dans un délai raisonnablement court une réponse suffisante à un problème posé; en particulier, certaines méthodes heuristiques visent souvent à obtenir très vite une solution correcte à un problème pour lequel l’obtention de la solution la meilleure, au moyen d’algorithmes connus, nécessiterait un temps considérable. Elle fait souvent usage de machines informatiques spéciales propres à faire des inférences: «Si l’enfant a des boutons, il y a une présomption de scarlatine, ou de rubéole... mais si en plus le taux d’antistreptolysine dans le sang est plus élevé que tant, alors il y a présomption complémentaire de scarlatine, etc.» On utilise pour cela des langages de haut niveau appropriés (Lisp, Prolog, etc.).7. Les télécommunicationsLes télécommunications, en fait la première grande application de l’électronique, ont assez peu évolué jusqu’à la fin de la Seconde Guerre mondiale: le téléphone est longtemps resté électromécanique, les voies téléphoniques transportant la parole sous forme analogique dans des fils métalliques enterrés ou traversant les océans, et leur commutation utilisant des relais.Depuis la fin de la Seconde Guerre mondiale sont apparues successivement, en concurrence des liaisons filaires métalliques, les transmissions hertziennes sous les formes de liaison directe de point à point (faisceaux ou câbles hertziens), de liaison de point à point avec réflexion sur la troposphère (faisceaux «troposphériques»), de liaison à travers un relais situé sur un satellite géostationnaire, de liaison terrestre de point à point à travers des câbles en fibres de verre (le signal électrique d’origine étant transformé en signal optique pendant la durée du transport). En même temps, le signal analogique se numérisait de plus en plus, permettant de s’affranchir des problèmes de distorsion au long du trajet, cette forme numérique de la transmission conduisant à la nécessité primaire de transmission à plus large bande passante, mais aussi à la possibilité de gestion par calculateur universel, à la possibilité d’utilisation des techniques de compression permettant de véhiculer des images sous forme très convenable dans des canaux de largeur de bande raisonnable.L’utilisation de faisceaux hertziens était la conséquence directe de l’utilisation et de la connaissance des micro-ondes (longueurs d’onde de quelques centimètres) rendues populaires par le radar: l’utilisation d’antennes à réflecteurs de grande dimension permettait de concentrer l’énergie émise dans des angles (solides) petits en direction du destinataire. Les réalisations correspondantes ont conduit durant les années soixante à la création d’une nouvelle industrie, sans incidence évidente sur les industries existantes des télécommunications. On peut en dire autant de l’émergence des faisceaux troposphériques, dont le marché n’a jamais été très important (à cause des contraintes inhérentes à cette technologie en matière de bande passante) et se trouve assez limité aux applications militaires ou équivalentes, ou à celles ne requérant que la transmission de peu d’informations mais sur de grandes distances.L’utilisation de satellites associés au sol à de grandes antennes (très grandes au début, beaucoup moins grandes ensuite) a aussi conduit à la création d’industries nouvelles sans gêner les industries plus conventionnelles.Sans doute en est-il de même de l’utilisation des fibres de verre pour transporter l’information, utilisation rendue possible par les progrès de la physico-chimie, qui donnent les moyens de réaliser des fibres de verre de qualité parfaitement contrôlée du centre au bord et les organes de transformation électrique-optique et optique-électrique performants associés.En revanche, la généralisation de l’emploi de signaux numériques au lieu de signaux analogiques, en particulier dans les transmissions téléphoniques, qui a commencé de se faire à partir du milieu des années soixante-dix, a constitué une véritable révolution parce qu’elle conduisait:– globalement, à une amélioration de la productivité dans le rapport 6 à 1 (six fois moins de personnel de fabrication, d’essais et d’installation par ligne d’abonné), donc à un énorme surplus de personnel et aux problèmes de licenciements associés;– à la nécessité d’utiliser un pourcentage très élevé d’ingénieurs dans une industrie employant jusque-là surtout du personnel d’exécution;– à l’introduction rapide de programmes d’informatique (logiciels) très compliqués et volumineux (en temps réel), correspondant à ce qu’on avait fait de plus complexe dans certaines applications militaires ou spatiales, dans une industrie qui n’était pas accoutumée à ces techniques;– à la possibilité enfin de fournir petit à petit aux utilisateurs des services nouveaux (utilisation du Minitel, réveil téléphonique automatique, transmission d’images fixes ou animées, «télématique», etc.) en mixant les possibilités de l’informatique et celle des transmissions.Le développement des nouveaux produits correspondants demandant des sommes importantes (plusieurs milliards de francs pour une nouvelle famille de centraux téléphoniques numériques dont la durée de vie tourne autour de cinq ans), il convenait dès lors de les amortir sur des séries importantes et d’éviter la dispersion des fabrications de quantités de modèles distincts et concurrents. D’où l’inévitable regroupement des industriels en quelques groupes puissants et peu nombreux, au moins pour les transmissions téléphoniques commerciales.L’industrie des télécommunications s’est de ce fait beaucoup modifiée: son chiffre d’affaires atteignait 336 milliards de francs en 1990 et représentait 7 p. 100 de la production mondiale avec un taux de croissance annuel de 5 p. 100.La répartition du chiffre d’affaires est la suivante: plus du tiers pour les trois premières sociétés (la française Alcatel, l’américaine A.T.T. et l’allemande Siemens), un petit tiers pour les sept suivantes (soit 42 p. 100 pour des sociétés contrôlées d’Europe, 32 p. 100 pour des sociétés contrôlées d’Amérique du Nord, 17 p. 100 pour des sociétés contrôlées du Japon).8. Les composantsLes composants étaient initialement des constituants élémentaires que l’on assemblait pour réaliser des fonctions. On a déjà dit que l’évolution de la technique et particulièrement des circuits intégrés avait étendu cette définition à des éléments de petite dimension assurant des fonctions plus ou moins complètes voire très complexes (microprocesseurs). On a coutume de classer les composants en trois catégories: les tubes à vide, les composants passifs et les semiconducteurs.Les tubes à vide – auxquels on ajoute certains composants «à l’état solide» à base de semiconducteurs qui assurent aujourd’hui des fonctions assurées autrefois par des tubes à vide – comportent essentiellement:– les triodes et tétrodes, utilisées surtout dans les émetteurs lorsqu’on a besoin d’émettre (radiodiffusion, accélérateurs de particules, générateurs de plasma) des puissances élevées à faible fréquence (exemple: tétrodes en ondes longues et courtes émettant des puissances de l’ordre de un mégawatt de façon continue);– les diodes et «éclateurs», qui servent d’interrupteurs ultrarapides;– les tubes micro-ondes (magnétrons, tubes amplificateurs à champs croisés, tubes à ondes progressives, klystrons), capables d’émettre des puissances élevées en ondes décimétriques et centimétriques;– les tubes de prises de vue pour caméra vidéo (vidicons, orthicons, etc.), pour caméra infrarouge (pyricons), pour «caméra» à rayons X;– leurs homologues à l’état solide (barettes et «rétines» en silicium à «transfert de charges» pour la détection en lumière visible et dans le proche infrarouge, en mercure-tellure-cadmium, ou en antimoniure d’indium, etc., pour la détection dans l’infrarouge);– les tubes à rayons cathodiques pour oscilloscopes d’instrumentation, pour oscilloscopes radar, et, bien sûr, pour téléviseurs domestiques, et les dispositifs de fonctions analogues à l’état solide (cristaux liquides commandés par des rétines de transistors à film mince);– les dispositifs d’imagerie à plasma et à électroluminescence.Les composants passifs proprement dits, auxquels on ajoutera les dispositifs électro-acoustiques, comportent essentiellement:– les résistances, de moins en moins utilisées seules;– les condensateurs, parmi lesquels il convient de citer à part les condensateurs d’énergie capables d’emmagasiner des énergies importantes (alors que longtemps on n’a pu guère dépasser un stockage de plus de quelques dizaines de joules par litre, on peut maintenant atteindre quelques centaines de joules par litre) et de les restituer en des temps très brefs (de l’ordre de la microseconde ou moins);– les connecteurs, capables de réunir des faisceaux de fils électriques;– les dispositifs électro-acoustiques utilisés soit pour fournir des références de fréquence (très stables) soit pour faire du traitement du signal (dispositifs «à onde de surface», en anglais S.A.W., pour surface acoustic waves );– les dispositifs utilisant du matériau magnétique (tel que des ferrites), pour les déviateurs des tubes cathodiques, ou pour les équipements en micro-onde.Même si l’on utilise des éléments semi-conducteurs dans les dispositifs de prise de vue déjà évoqués, on ne regroupe le plus souvent sous le terme d’industrie des semi-conducteurs que ce qui touche aux diodes, transistors et circuits intégrés au silicium d’une part, et ce qui touche aux mêmes éléments en composés III-V d’autre part.L’industrie du silicium comporte, d’une part, l’industrie des éléments «discrets», diodes et transistors, utilisés pour fournir de la puissance en basse fréquence et en micro-ondes (on peut obtenir 1 kilowatt moyen en ondes assez longues avec «un» transistor, en fait une association de nombreux transistors en parallèle sur la même puce) ou à la réception (par exemple diodes de détection ou de mélange), d’autre part, l’industrie des circuits intégrés.Les circuits intégrés se répartissent en circuits linéaires (tels que ceux qui sont utilisés pour faire du codage analogique-numérique et sont donc essentiels avec l’évolution vers un traitement du signal de plus en plus numérique) et en circuits numériques, utilisés en traitement du signal en aval des précédents et, bien sûr, dans tous les dispositifs de calcul.Sur le plan technologique, il existe deux grandes familles de circuits intégrés: les circuits à base de transistors bipolaires, les premiers utilisés et industrialisés, et les circuits à base de transistors M.O.S. (metal oxyde semiconductor ), les premiers imaginés sans doute, au début des années trente.Les circuits bipolaires sont intrinsèquement plus rapides, mais dissipent plus de puissance et ne permettent pas de mettre autant de fonctions sur la même surface de silicium que les circuits M.O.S., moins rapides intrinsèquement mais dissipant moins de puissance, surtout les circuits dits C.M.O.S. (le C pour complementary ). Dans les deux types de circuits, l’évolution de la technologie permet de faire des dessins de circuits de plus en plus fins (et de les fabriquer avec un pourcentage suffisant de succès, grâce à l’utilisation de précautions plus importantes dans des salles de plus en plus dépoussiérées), et de ce fait d’obtenir des vitesses de fonctionnement de plus en plus grandes ainsi qu’un nombre de transistors par pastille (par puce, en anglais chip ) en augmentation constante. L’état de l’art au début des années quatre-vingt-dix permettait de réaliser industriellement des dessins où les détails les plus petits étaient de 1 micromètre et, au stade du laboratoire, de 0,5 micromètre. Ces mêmes dimensions étaient respectivement de 6 et de 3 micromètres à la fin des années soixante-dix.Certains circuits spéciaux destinés à fonctionner en dépit de rayonnements (cosmiques ou provenant d’explosions nucléaires) sont réalisés sur des supports («substrats») qui ne sont pas en silicium, mais en alumine ou en zircon... c’est-à-dire en saphir ou en zircone.La fabrication de circuits intégrés repose sur une série (de dix à quinze) d’opérations successives (photographie, dite photogravure, qui peut utiliser des faisceaux d’électrons plutôt que des rayons lumineux pour donner des dessins plus fins; oxydation du silicium; implantation d’impuretés en nombre très contrôlé par projection très vigoureuse de ces impuretés sur le substrat...) appelée filière, à partir de dessins réalisés par des «concepteurs» grâce à l’aide d’outils informatiques (conception assistée par ordinateur, ou C.A.O.). La C.A.O. utilise des simulateurs pour le calcul des résultats probables, aide à définir les séquences de test qui permettront de vérifier (suffisamment) que le circuit final est bon. Elle utilise des ordinateurs qui ont besoin d’être de plus en plus puissants à mesure qu’il y a plus de fonctions différentes sur la même pastille, et des programmes qui ont besoin d’être de mieux en mieux structurés.Les utilisateurs cherchent souvent à réaliser eux-mêmes des circuits intégrés adaptés à leurs besoins spécifiques en faisant leur propre conception en association avec un «fondeur» qui, disposant de «filières» bien au point, peut à la fois fournir les données de base nécessaires à la C.A.O. (outils de compilation) et ensuite effectuer physiquement sur le silicium les opérations délicates de physico-chimie nécessaires pour obtenir le circuit intégré final.Les composés III-V sont variés, mais les premiers qui ont vu le jour industriellement sont les composés à base d’arséniure de gallium (certains sont d’ailleurs fabriqués sur un substrat de silicium). Quoique ne bénéficiant pas de l’avantage considérable que connaît le silicium d’avoir un oxyde (la silice) extraordinairement stable et protecteur, les composés III-V possèdent des propriétés intéressantes:– ils permettent de faire des lasers (de très petite dimension) fournissant des sources intenses de lumière pure;– ils permettent de réaliser des circuits intégrés fournissant des fonctions complètes micro-ondes (circuits dits M.M.I.C. – monolithic microwave integrated circuits );– ils permettent de faire des organisations nouvelles à base d’empilements de couches très fines de corps différents (hétéroépitaxies), tels que les T.E.G.-F.E.T. de Thomson-C.S.F. (two dimensions electron gas-field effect transistor ) ou les H.E.M.T. des Américains et des Japonais (high electron mobility transistor );– ils sont enfin plus rapides intrinsèquement que leurs homologues au silicium.En revanche, toutes choses égales par ailleurs, ils sont plus coûteux que leurs homologues au silicium quand ceux-ci existent.Les statistiques relatives à la production des composants sont délicates à exploiter, car elles reposent le plus souvent sur le chiffre d’affaires correspondant, négligeant complètement l’activité effectuée par certains industriels pour leurs propres équipements. Les cinq premiers fabricants de semi-conducteurs sont Nec, Toshiba, Hitachi, Motorola et Intel. La production de composants par les sociétés japonaises est supérieure à celle des sociétés américaines, sans doute de deux à trois fois plus élevée que celle des sociétés européennes.9. Un autre mode de classificationLa classification de l’industrie électronique telle qu’elle vient d’être donnée correspond aux statistiques, aux organisations professionnelles, et résulte du passé.Il est utile d’en présenter une autre, selon laquelle l’électronique apparaît aujourd’hui segmentée en trois branches finalement très différentes, tellement différentes qu’il est en général tout à fait déconseillé d’en pratiquer deux dans la même unité (usine, division ou petite filiale).Dans la première branche, que l’on peut qualifier de branche grand public , on fabrique des produits dont le prix unitaire est rarement supérieur à 7 000 francs et dont plus d’un million d’exemplaires par an sortent de la même unité de production. Cette importante quantité de produits peu coûteux est fabriquée avec des moyens très automatisés, ce qui permet d’obtenir une excellente fiabilité, mise en évidence par le fait que le rapport:

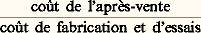

est faible (10 p. 100) et diminue avec le temps.Les téléviseurs couleurs et les magnétoscopes ressortissent à l’électronique grand public, comme ce sera bientôt le cas pour les produits d’électronique automobile et les terminaux téléphoniques de toute nature.La deuxième branche est celle de l’électronique professionnelle au sens large du terme: les produits fabriqués ont un prix supérieur à 100 000 francs, qui dépasse souvent plusieurs millions de francs (jusqu’à 200 millions de francs). Ils sont fabriqués en petite quantité (inférieure à quelques milliers d’exemplaires par an) voire en très petite quantité (moins de un par an), pour des clients étatiques ou équivalents. Un système A.B.S. pour Airbus est un équipement d’électronique professionnelle (par opposition au système équivalent pour les véhicules automobiles, qui est devenu grand public au début des années quatre-vingt-dix). Le coût de l’après-vente rapporté au coût de fabrication et d’essais reste faible (de 10 à 40 p. 100), non pas tant à cause de la fiabilité intrinsèque des équipements (in fine moins bonne que celle des équipements grand public), mais grâce à la compétence des utilisateurs (abondamment fournis en documentation bien faite, et instruits pendant de nombreux mois par les soins du constructeur). La performance est une qualité essentielle de ces équipements. L’électronique professionnelle décrite ci-dessus rentre dans cette branche, comme les équipements de commutation téléphonique publique, comme les faisceaux hertziens, les équipements de satellites, les équipements d’aéronautique militaire ou civile, la radioémission...La troisième branche, enfin, est celle que l’on qualifie parfois d’électronique institutionnelle . Le prix des équipements se situe entre 15 000 francs et quelques millions de francs. La quantité fabriquée annuellement par unité de production varie de 1 000 à 100 000. Le coût de l’après-vente rapporté au coût de fabrication et d’essais est élevé (pouvant atteindre 200 p. 100), car si les équipements fournis sont d’assez bonne qualité, ils sont servis par des utilisateurs qui n’ont pas été formés à cet effet, et qui disposent d’une documentation sommaire. Cette branche recouvre la téléphonie privée, l’essentiel de l’instrumentation et, surtout, l’essentiel de l’informatique.Une autre façon de distinguer ces trois branches est de dire que le mot clef en grand public est usine , en professionnel, recherche et développement , en institutionnel, réseau : la dernière chose à sacrifier en électronique grand public sont les investissements, en électronique professionnelle la recherche et développement, en électronique institutionnelle, l’après-vente.On notera au passage qu’un produit électronique d’un prix de 10 000 francs fabriqué à 200 000 exemplaires ne rentre dans aucune branche, généralement parce qu’il est dans une situation instable, donc provisoire; pour devenir grand public, sa production doit être augmentée et son prix diminué; pour devenir institutionnel, les services doivent être augmentés. Très souvent, il disparaît.L’imagerie médicale est dans une situation particulière: il s’agissait clairement, au début des années soixante-dix, d’un métier institutionnel. L’invention du scanner par des personnes de l’électronique professionnelle (puis des appareils d’imagerie par résonance magnétique nucléaire) a changé la situation, de sorte qu’une partie importante (excepté les échographes) de ce métier est devenue presque professionnelle («presque» parce que les utilisateurs n’ont pas encore la compétence suffisante – ou la formation – pour assurer eux-mêmes l’essentiel de la maintenance des équipements). La transition entre le caractère institutionnel du passé et l’aspect professionnel explique les tourments qu’a subis la profession correspondante.Quant aux composants électroniques , on peut les classer en trois catégories de façon un peu analogue: les composants d’emploi général; les composants typiquement grand public (tubes cathodiques shadow-mask ou équivalents pour téléviseurs couleurs grand public, haut-parleurs de téléviseurs, etc.); les composants typiquement professionnels (utilisés dans les satellites, dans les matériels militaires «durcis», c’est-à-dire protégés contre les radiations, les tubes micro-ondes pour radars et faisceaux hertziens, etc.).À titre d’exemple, un dispositif d’écran plat de visualisation à cristaux liquides contrôlés par un réseau de transistors en silicium amorphe en film mince pourra être professionnel (destiné à être implanté dans des avions de ligne ou de combat), donc fabriqué en quelques centaines (ou milliers) d’exemplaires par an et devant tenir dans des environnements sévères sans grand besoin de fournir des couleurs très réalistes, ou pourra être grand public pour équiper les récepteurs couleurs de télévision sans contraintes liées à l’environnement, mais avec la nécessité d’une excellente reproduction des couleurs; il sera alors à terme fabriqué en énormes quantités. Les deux industries correspondantes sont très différentes à beaucoup d’égards.10. L’évolution de l’électroniqueL’évolution de l’électronique durant les années quatre-vingt-dix s’est dessinée au travers de ce qui précède. Une caractéristique essentielle de cette évolution réside dans le rôle de la technologie .En schématisant, on peut dire que l’informatique serait restée une petite industrie si le transistor planar n’avait pas été inventé, mais que l’essentiel des machines informatiques utilisent le vieux schéma de von Neumann. À l’autre extrémité, les montres modernes (à quartz, circuits intégrés et souvent affichage à cristaux liquides) n’ont existé que grâce aux progrès de la technologie.En schématisant toujours, on peut dire que l’important aujourd’hui n’est plus comme dans les années cinquante d’inventer de nouveaux concepts mais de trouver les moyens pratiques d’utiliser de vieux concepts pour réaliser des équipements plus performants, ou moins coûteux.Qu’est-ce que la «technologie» en électronique? Ce sont de nouveaux matériaux, de nouveaux traitements de ces matériaux, de la microlithographie, de la conception assistée par ordinateur et des tests.Les nouveaux matériaux sont les fibres de carbone, les matériaux composites, le nitrure d’aluminium, les cristaux liquides, le silicium amorphe, les pérovskites supraconductrices à température pas trop basse et, bien sûr, la grande famille des composés III-V, sans compter les polymères nouveaux (piézoélectriques); il ne s’agit là que de quelques exemples de matériaux inédits (peu utilisés autrefois ou utilisés pour d’autres raisons) qui ont permis des progrès essentiels en électronique.En ce qui concerne les nouveaux traitements de ces matériaux , l’implantation (injection en force d’impuretés dans un substrat semiconducteur), l’épitaxie par jet moléculaire (vaporisation de produits dans l’ultravide de façon contrôlée) permettent la réalisation de couches superposées d’épaisseur contrôlée de matériaux cristallisés différents, pour réaliser des cristaux artificiels; l’utilisation de l’impesanteur, de réactions nucléaires, etc., ont ouvert la voie à de nouveaux produits, de nouvelles structures de composants, donc à des équipements de performances inédites.La microlithographie , qui permet de graver les dessins très fins des circuits intégrés très denses, après s’être contentée de lumière visible (jusqu’à des finesses de 1 micromètre environ), puis de gravure à faisceau d’électrons (permettant de descendre à des finesses d’environ 2 dixièmes de micromètre) devra ouvrir une place à la gravure par faisceau d’ions ou par rayons X pour atteindre des finesses accrues.La conception assistée par ordinateur permettra de réaliser des circuits intégrés encore plus complexes, devra utiliser des machines informatiques de plus en plus puissantes, avec des programmes de plus en plus sophistiqués.Or il semble bien que les outils nécessaires demain en technologie seront beaucoup plus chers que ceux d’aujourd’hui (en coût d’achat ou de production des outils eux-mêmes, en coût de formation du personnel qui les utilisera). À titre d’exemple, le prix d’un appareil de test de circuits intégrés performant (150 entrées/sorties) était de quelques millions de francs. Il est maintenant (pour des circuits de 250 entrées/sorties) de quelques dizaines de millions de francs. Il est probable qu’il atteindra à la fin des années quatre-vingt-dix des sommes extraordinaires: peu pourront l’acheter en France (faut-il dire en Europe?).Il s’agit là, avec les coûts énormes des outils de développement des logiciels, de l’une des raisons qui inciteront à de nouveaux regroupements industriels en électronique, et à des accords de coopération internationale pour réduire les dépenses (fixes) de recherche et développement.